728x90

Traffic control: Fine-grained traffic routing

Reducing risk even further: Traffic mirroring

- 운영 환경 트래픽을 새 디플로이먼트로 미러링하는 것으로, 그림 5.10처럼 운영 환경 트래픽을 복사해 고객 트래픽 범위 외부의 새 디플로이먼트로 보내는 것

- 미러링 방식을 사용하면, 실제 운영 환경 트래픽을 배포로 보냄으로써 사용자에게 영향을 주지 않고 새 코드가 어떻게 동작할지에 대한 실제 피드백을 얻을 수 있다.

- 이스티오는 트래픽 미러링을 지원하며, 이는 배포 및 릴리스 수행의 위험성을 다른 두 방식보다 휠씬 더 줄일 수 있다.

※ 미러링 Mirroring vs. 복제 Replication 의 용어의 차이? 동작의 차이는?

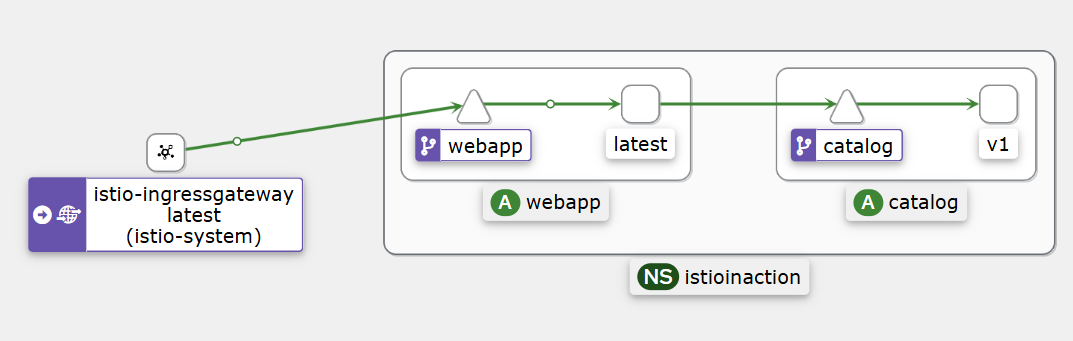

- 실습 환경 초기화 (실습)

# catalog 디플로이먼트를 초기 상태로 돌리고, catalog-v2 를 별도의 디플로이먼트로 배포

kubectl apply -f services/catalog/kubernetes/catalog-svc.yaml -n istioinaction

kubectl apply -f services/catalog/kubernetes/catalog-deployment.yaml -n istioinaction

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction

kubectl apply -f ch5/catalog-dest-rule.yaml -n istioinaction

kubectl apply -f ch5/catalog-vs-v1-mesh.yaml -n istioinaction

# 확인

kubectl get deploy -n istioinaction -o wide

kubectl get svc,ep -n istioinaction -owide

kubectl get gw,vs -n istioinaction

# 반복 접속

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# catalog v1 으로만 접속 확인

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

0

- 트래픽 미러링 (실습)

# cat ch5/catalog-vs-v2-mirror.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways:

- mesh

http:

- route:

- destination:

host: catalog

subset: version-v1

weight: 100

mirror:

host: catalog

subset: version-v2- 이 VS는 라이브 트래픽을 전부 catalog(v1)으로 보내지만, 동시에 v2로도 미러링한다.

- 미러링은 요청의 복사복을 만들어 미러링된 클러스터(여기서는 catalog-v2)로 전송하는 이른바 ‘보내고 잊는 방식’으로 수행된다.

- 미러링된 요청은 실제 요청에는 영향을 줄 수 없는데, 미러링을 수행하는 이스티오 프록시가 미러링된 클러스터에서 오는 응답을 모두(성공인든, 실패든) 무시해버리기 때문이다.

- VS 리소스를 만들어보자

# 반복 접속

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; don

# catalog istio-proxy 로그 활성화

cat << EOF | kubectl apply -f -

apiVersion: telemetry.istio.io/v1alpha1

kind: Telemetry

metadata:

name: catalog

namespace: istioinaction

spec:

accessLogging:

- disabled: false

providers:

- name: envoy

selector:

matchLabels:

app: catalog

EOF

kubectl get telemetries -n istioinaction

NAME AGE

catalog 16s

webapp 5h49m

# istio-proxy 로그 확인 : 신규 터미널

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

kubectl logs -n istioinaction -l app=catalog -c istio-proxy -f

kubectl logs -n istioinaction -l version=v1 -c istio-proxy -f

kubectl logs -n istioinaction -l app=catalog -l version=v2 -c istio-proxy -f

혹은

kubectl stern -n istioinaction -l app=catalog -c istio-proxy

# proxy-config : webapp

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction | grep catalog

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction | grep catalog

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | grep catalog

# proxy-config : catalog

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction | grep catalog

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction | grep catalog

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction | grep catalog

# 미러링 VS 설정

kubectl apply -f ch5/catalog-vs-v2-mirror.yaml -n istioinaction

# v1 으로만 호출 확인

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

0

# v1 app 로그 확인

kubectl logs -n istioinaction -l app=catalog -l version=v1 -c catalog -f

request path: /items

blowups: {}

number of blowups: 0

GET catalog.istioinaction:80 /items 200 502 - 0.375 ms

GET /items 200 0.375 ms - 502

...

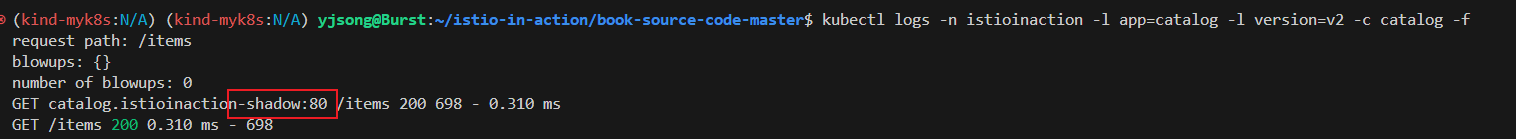

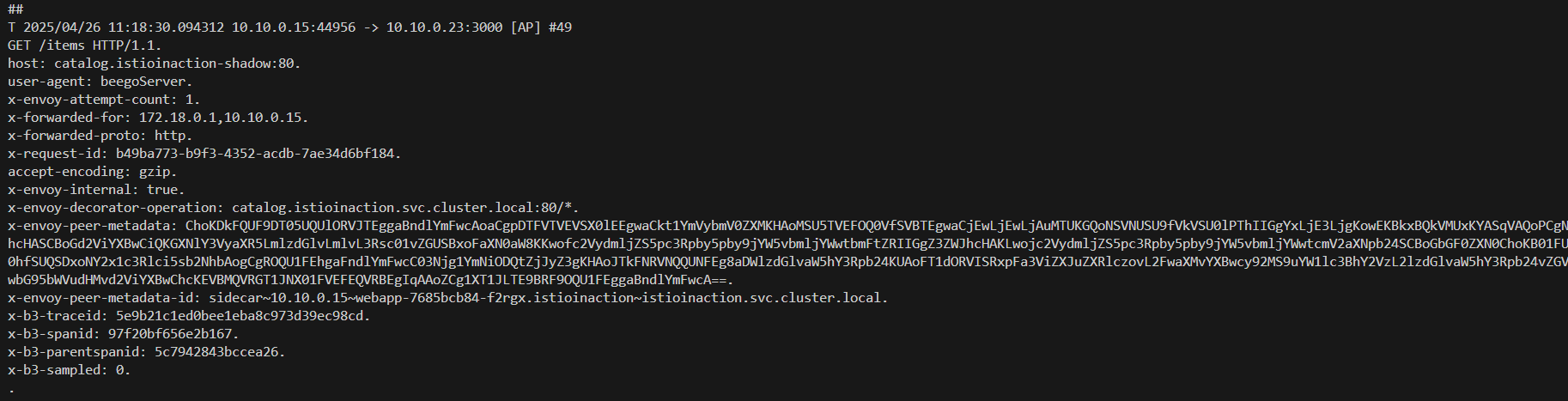

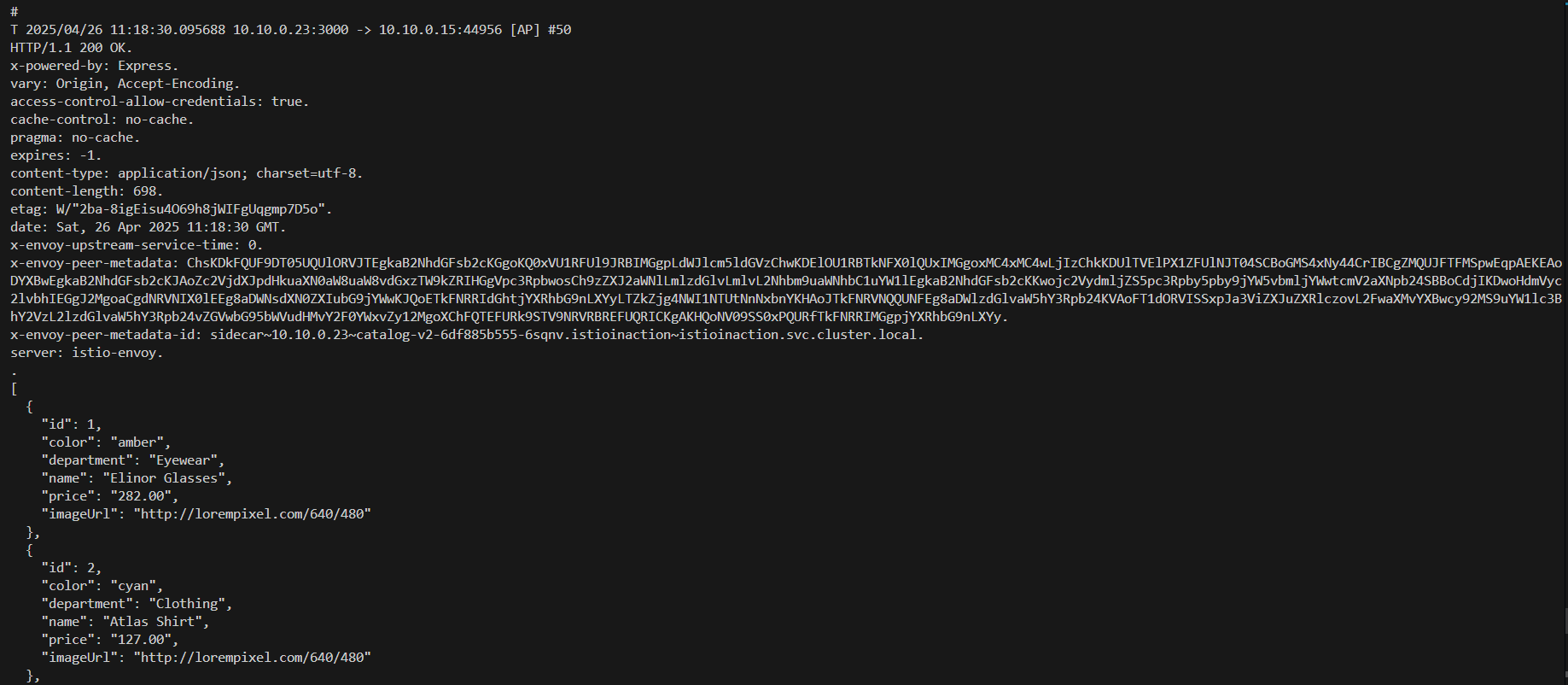

# v2 app 로그 확인 : 미러링된 트래픽이 catalog v2로 향할때, Host 헤더가 수정돼 미러링/섀도잉된 트래픽임을 나타낸다.

## 따라서 Host:catalog:8080 대신 Host:catalog-shadow:8080이 된다.

## -shadow 접미사가 붙은 요청을 받는 서비스는 그 요청이 미러링된 요청임을 식별할 수 있어, 요청을 처리할 때 고려할 수 있다

## 예를 들어, 응답이 버려질 테니 트랜잭션을 롤백하지 않거나 리소스를 많이 사용하는 호출을 하지 않는 것 등.

kubectl logs -n istioinaction -l app=catalog -l version=v2 -c catalog -f

request path: /items

blowups: {}

number of blowups: 0

GET catalog.istioinaction-shadow:80 /items 200 698 - 0.503 ms

GET /items 200 0.503 ms - 698

#

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json > webapp-routes.json

cat webapp-routes.json

...

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"timeout": "0s",

"retryPolicy": {

"retryOn": "connect-failure,refused-stream,unavailable,cancelled,retriable-status-codes",

"numRetries": 2,

"retryHostPredicate": [

{

"name": "envoy.retry_host_predicates.previous_hosts",

"typedConfig": {

"@type": "type.googleapis.com/envoy.extensions.retry.host.previous_hosts.v3.PreviousHostsPredicate"

}

}

],

"hostSelectionRetryMaxAttempts": "5",

"retriableStatusCodes": [

503

]

},

"requestMirrorPolicies": [

{

"cluster": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"runtimeFraction": {

"defaultValue": {

"numerator": 100

}

},

"traceSampled": false

...

# 위 webapp과 상동 : 그거슨 mesh(gateway)이니까...

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction --name 80 -o json > webapp-routes.json

cat catalog-routes.json

...

- (심화) webapp 과 catalog v2 파드에서 패킷 덤프로 확인

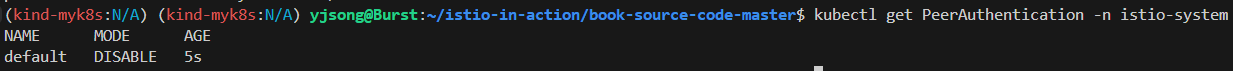

# Istio 메시 내부망에서 모든 mTLS 통신 기능 끄기 설정 : (참고) 특정 네임스페이스 등 세부 조절 설정 가능

cat <<EOF | kubectl apply -f -

apiVersion: security.istio.io/v1beta1

kind: PeerAuthentication

metadata:

name: default

namespace: istio-system

spec:

mtls:

mode: DISABLE

EOF

kubectl get PeerAuthentication -n istio-system

NAME MODE AGE

default DISABLE 6h13m

--------------------------------------------------------------------------------

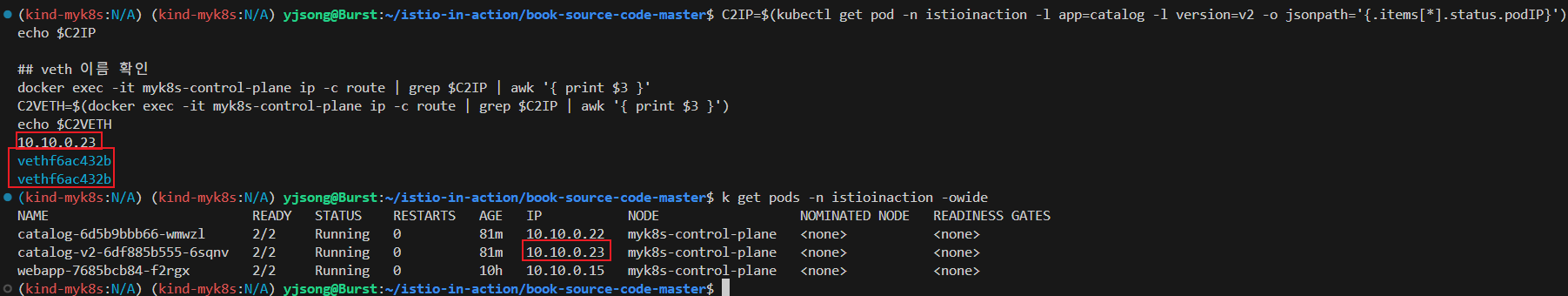

# catalog v2 파드의 vnic 와 vritual-pair 인 control-plane 노드(?)의 veth 이름 찾기

## catalog v2 파드 IP 확인

C2IP=$(kubectl get pod -n istioinaction -l app=catalog -l version=v2 -o jsonpath='{.items[*].status.podIP}')

echo $C2IP

## veth 이름 확인

docker exec -it myk8s-control-plane ip -c route | grep $C2IP | awk '{ print $3 }'

C2VETH=$(docker exec -it myk8s-control-plane ip -c route | grep $C2IP | awk '{ print $3 }')

echo $C2VETH

10.10.0.23

vethf6ac432b

--------------------------------------------------------------------------------

# ngrep 확인(메모 정보 직접 기입!) : catalog v2 파드 tcp 3000

docker exec -it myk8s-control-plane sh -c "ngrep -tW byline -d vethf6ac432b '' 'tcp port 3000'"

## 요청

T 2025/04/26 11:18:31.105759 10.10.0.15:44950 -> 10.10.0.23:3000 [AP] #52

GET /items HTTP/1.1.

host: catalog.istioinaction-shadow:80.

user-agent: beegoServer.

x-envoy-attempt-count: 1.

x-forwarded-for: 172.18.0.1,10.10.0.15.

x-forwarded-proto: http.

x-request-id: 03e6e06b-04ce-40d3-a1c5-1caf29731635.

accept-encoding: gzip.

x-envoy-internal: true.

x-envoy-decorator-operation: catalog.istioinaction.svc.cluster.local:80/*.

x-envoy-peer-metadata: ChoKDkFQUF9DT05UQUlORVJTEggaBndlYmFwcAoaCgpDTFVTVEVSX0lEEgwaCkt1YmVybmV0ZXMKHAoMSU5TVEFOQ0VfSVBTEgwaCjEwLjEwLjAuMTUKGQoNSVNUSU9fVkVSU0lPThIIGgYxLjE3LjgKowEKBkxBQkVMUxKYASqVAQoPCgNhcHASCBoGd2ViYXBwCiQKGXNlY3VyaXR5LmlzdGlvLmlvL3Rsc01vZGUSBxoFaXN0aW8KKwofc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtbmFtZRIIGgZ3ZWJhcHAKLwojc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtcmV2aXNpb24SCBoGbGF0ZXN0ChoKB01FU0hfSUQSDxoNY2x1c3Rlci5sb2NhbAogCgROQU1FEhgaFndlYmFwcC03Njg1YmNiODQtZjJyZ3gKHAoJTkFNRVNQQUNFEg8aDWlzdGlvaW5hY3Rpb24KUAoFT1dORVISRxpFa3ViZXJuZXRlczovL2FwaXMvYXBwcy92MS9uYW1lc3BhY2VzL2lzdGlvaW5hY3Rpb24vZGVwbG95bWVudHMvd2ViYXBwChcKEVBMQVRGT1JNX01FVEFEQVRBEgIqAAoZCg1XT1JLTE9BRF9OQU1FEggaBndlYmFwcA==.

x-envoy-peer-metadata-id: sidecar~10.10.0.15~webapp-7685bcb84-f2rgx.istioinaction~istioinaction.svc.cluster.local.

x-b3-traceid: 07eeba4e88f55689b2e1bca41d803ace.

x-b3-spanid: 639d6870339e3cfb.

x-b3-parentspanid: feabbada7b66b6e0.

x-b3-sampled: 0.

.

## 응답

T 2025/04/26 11:18:31.107178 10.10.0.23:3000 -> 10.10.0.15:44950 [AP] #53

HTTP/1.1 200 OK.

x-powered-by: Express.

vary: Origin, Accept-Encoding.

access-control-allow-credentials: true.

cache-control: no-cache.

pragma: no-cache.

expires: -1.

content-type: application/json; charset=utf-8.

content-length: 698.

etag: W/"2ba-8igEisu4O69h8jWIFgUqgmp7D5o".

date: Sat, 26 Apr 2025 11:18:31 GMT.

x-envoy-upstream-service-time: 1.

x-envoy-peer-metadata: ChsKDkFQUF9DT05UQUlORVJTEgkaB2NhdGFsb2cKGgoKQ0xVU1RFUl9JRBIMGgpLdWJlcm5ldGVzChwKDElOU1RBTkNFX0lQUxIMGgoxMC4xMC4wLjIzChkKDUlTVElPX1ZFUlNJT04SCBoGMS4xNy44CrIBCgZMQUJFTFMSpwEqpAEKEAoDYXBwEgkaB2NhdGFsb2cKJAoZc2VjdXJpdHkuaXN0aW8uaW8vdGxzTW9kZRIHGgVpc3RpbwosCh9zZXJ2aWNlLmlzdGlvLmlvL2Nhbm9uaWNhbC1uYW1lEgkaB2NhdGFsb2cKKwojc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtcmV2aXNpb24SBBoCdjIKDwoHdmVyc2lvbhIEGgJ2MgoaCgdNRVNIX0lEEg8aDWNsdXN0ZXIubG9jYWwKJQoETkFNRRIdGhtjYXRhbG9nLXYyLTZkZjg4NWI1NTUtNnNxbnYKHAoJTkFNRVNQQUNFEg8aDWlzdGlvaW5hY3Rpb24KVAoFT1dORVISSxpJa3ViZXJuZXRlczovL2FwaXMvYXBwcy92MS9uYW1lc3BhY2VzL2lzdGlvaW5hY3Rpb24vZGVwbG95bWVudHMvY2F0YWxvZy12MgoXChFQTEFURk9STV9NRVRBREFUQRICKgAKHQoNV09SS0xPQURfTkFNRRIMGgpjYXRhbG9nLXYy.

x-envoy-peer-metadata-id: sidecar~10.10.0.23~catalog-v2-6df885b555-6sqnv.istioinaction~istioinaction.svc.cluster.local.

server: istio-envoy.

.

[

{

"id": 1,

"color": "amber",

"department": "Eyewear",

"name": "Elinor Glasses",

"price": "282.00",

"imageUrl": "http://lorempixel.com/640/480"

},

{

"id": 2,

"color": "cyan",

"department": "Clothing",

"name": "Atlas Shirt",

"price": "127.00",

"imageUrl": "http://lorempixel.com/640/480"

},

{

"id": 3,

"color": "teal",

"department": "Clothing",

"name": "Small Metal Shoes",

"price": "232.00",

"imageUrl": "http://lorempixel.com/640/480"

},

{

"id": 4,

"color": "red",

"department": "Watches",

"name": "Red Dragon Watch",

"price": "232.00",

"imageUrl": "http://lorempixel.com/640/480"

}

]

- 미러링 대상 서버는 응답을 안하는게 좋지만, 만약 응답을 webapp 파드에 한다 해도, webapp은 받고 나서 무시(drop?) 처리함.

--------------------------------------------------------------------------------

# webapp 파드의 vnic 와 vritual-pair 인 control-plane 노드(?)의 veth 이름 찾기

## webapp 파드 IP 확인

WEBIP=$(kubectl get pod -n istioinaction -l app=webapp -o jsonpath='{.items[*].status.podIP}')

echo $WEBIP

## veth 이름 확인

docker exec -it myk8s-control-plane ip -c route | grep $WEBIP | awk '{ print $3 }'

WEBVETH=$(docker exec -it myk8s-control-plane ip -c route | grep $WEBIP | awk '{ print $3 }')

echo $WEBVETH

10.10.0.15

veth37861f50 <- 해당 이름을 메모해두기

--------------------------------------------------------------------------------

# ngrep 확인(메모 정보 직접 기입!) : webapp 파드 tcp 8080

## => 아래 tcp 3000에서 미러링 응답이 있지만 8080에 없다는건, webapp istio-proxy 가 최초 외부 요청자에게는 전달하지 않고 무시(drop?).

docker exec -it myk8s-control-plane sh -c "ngrep -tW byline -d veth37861f50 '' 'tcp port 8080'"

## 요청

T 2025/04/26 11:25:15.070586 10.10.0.4:33460 -> 10.10.0.15:8080 [AP] #13

HEAD /api/catalog HTTP/1.1.

host: webapp.istioinaction.io:30000.

user-agent: curl/8.5.0.

accept: */*.

x-forwarded-for: 172.18.0.1.

x-forwarded-proto: http.

x-envoy-internal: true.

x-request-id: d5987602-0a1c-4f11-9d2e-4f413ddf9ae3.

x-envoy-decorator-operation: webapp.istioinaction.svc.cluster.local:80/*.

x-envoy-peer-metadata: ChQKDkFQUF9DT05UQUlORVJTEgIaAAoaCgpDTFVTVEVSX0lEEgwaCkt1YmVybmV0ZXMKGwoMSU5TVEFOQ0VfSVBTEgsaCTEwLjEwLjAuNAoZCg1JU1RJT19WRVJTSU9OEggaBjEuMTcuOAqcAwoGTEFCRUxTEpEDKo4DCh0KA2FwcBIWGhRpc3Rpby1pbmdyZXNzZ2F0ZXdheQoTCgVjaGFydBIKGghnYXRld2F5cwoUCghoZXJpdGFnZRIIGgZUaWxsZXIKNgopaW5zdGFsbC5vcGVyYXRvci5pc3Rpby5pby9vd25pbmctcmVzb3VyY2USCRoHdW5rbm93bgoZCgVpc3RpbxIQGg5pbmdyZXNzZ2F0ZXdheQoZCgxpc3Rpby5pby9yZXYSCRoHZGVmYXVsdAowChtvcGVyYXRvci5pc3Rpby5pby9jb21wb25lbnQSERoPSW5ncmVzc0dhdGV3YXlzChIKB3JlbGVhc2USBxoFaXN0aW8KOQofc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtbmFtZRIWGhRpc3Rpby1pbmdyZXNzZ2F0ZXdheQovCiNzZXJ2aWNlLmlzdGlvLmlvL2Nhbm9uaWNhbC1yZXZpc2lvbhIIGgZsYXRlc3QKIgoXc2lkZWNhci5pc3Rpby5pby9pbmplY3QSBxoFZmFsc2UKGgoHTUVTSF9JRBIPGg1jbHVzdGVyLmxvY2FsCi4KBE5BTUUSJhokaXN0aW8taW5ncmVzc2dhdGV3YXktOTk2YmM2YmI2LTg0bXYyChsKCU5BTUVTUEFDRRIOGgxpc3Rpby1zeXN0ZW0KXQoFT1dORVISVBpSa3ViZXJuZXRlczovL2FwaXMvYXBwcy92MS9uYW1lc3BhY2VzL2lzdGlvLXN5c3RlbS9kZXBsb3ltZW50cy9pc3Rpby1pbmdyZXNzZ2F0ZXdheQoXChFQTEFURk9STV9NRVRBREFUQRICKgAKJwoNV09SS0xPQURfTkFNRRIWGhRpc3Rpby1pbmdyZXNzZ2F0ZXdheQ==.

x-envoy-peer-metadata-id: router~10.10.0.4~istio-ingressgateway-996bc6bb6-84mv2.istio-system~istio-system.svc.cluster.local.

x-envoy-attempt-count: 1.

x-b3-traceid: a80dac9e7784ab6fc08619d7b5334f4d.

x-b3-spanid: c08619d7b5334f4d.

x-b3-sampled: 0.

.

## 응답

T 2025/04/26 11:25:15.074152 10.10.0.15:8080 -> 10.10.0.4:33460 [AP] #15

HTTP/1.1 200 OK.

content-length: 357.

content-type: application/json; charset=utf-8.

date: Sat, 26 Apr 2025 11:25:15 GMT.

x-envoy-upstream-service-time: 3.

x-envoy-peer-metadata: ChoKDkFQUF9DT05UQUlORVJTEggaBndlYmFwcAoaCgpDTFVTVEVSX0lEEgwaCkt1YmVybmV0ZXMKHAoMSU5TVEFOQ0VfSVBTEgwaCjEwLjEwLjAuMTUKGQoNSVNUSU9fVkVSU0lPThIIGgYxLjE3LjgKowEKBkxBQkVMUxKYASqVAQoPCgNhcHASCBoGd2ViYXBwCiQKGXNlY3VyaXR5LmlzdGlvLmlvL3Rsc01vZGUSBxoFaXN0aW8KKwofc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtbmFtZRIIGgZ3ZWJhcHAKLwojc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtcmV2aXNpb24SCBoGbGF0ZXN0ChoKB01FU0hfSUQSDxoNY2x1c3Rlci5sb2NhbAogCgROQU1FEhgaFndlYmFwcC03Njg1YmNiODQtZjJyZ3gKHAoJTkFNRVNQQUNFEg8aDWlzdGlvaW5hY3Rpb24KUAoFT1dORVISRxpFa3ViZXJuZXRlczovL2FwaXMvYXBwcy92MS9uYW1lc3BhY2VzL2lzdGlvaW5hY3Rpb24vZGVwbG95bWVudHMvd2ViYXBwChcKEVBMQVRGT1JNX01FVEFEQVRBEgIqAAoZCg1XT1JLTE9BRF9OQU1FEggaBndlYmFwcA==.

x-envoy-peer-metadata-id: sidecar~10.10.0.15~webapp-7685bcb84-f2rgx.istioinaction~istioinaction.svc.cluster.local.

server: istio-envoy.

.

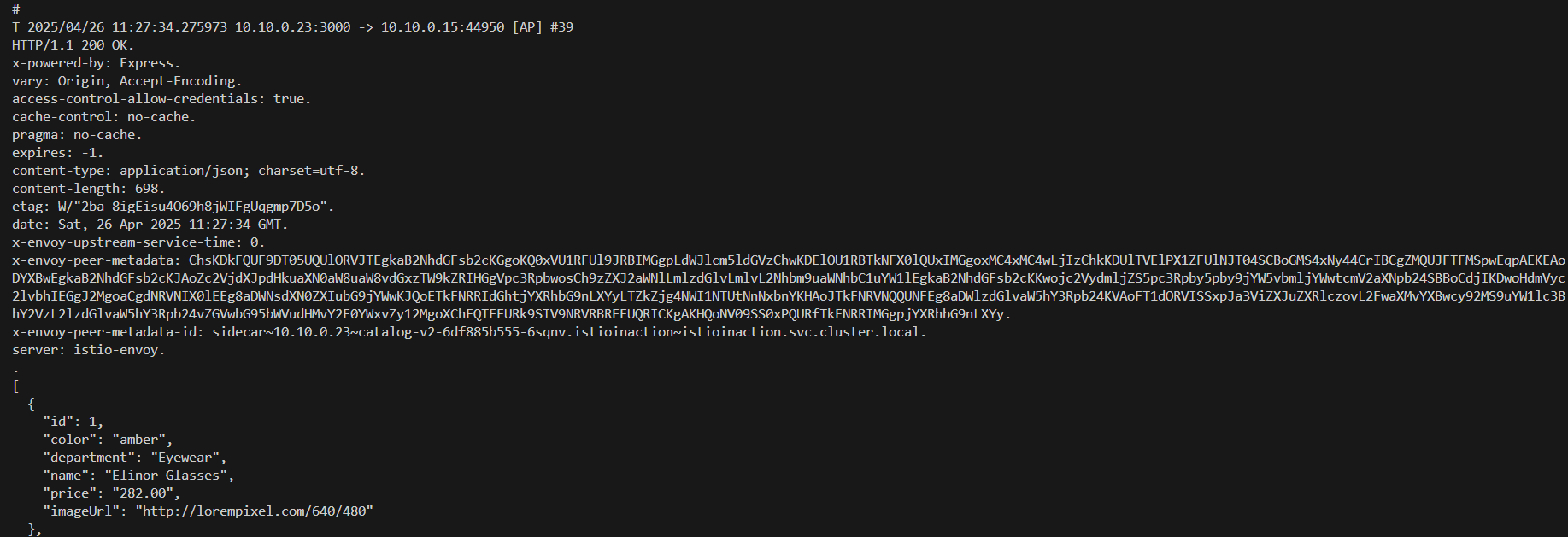

# ngrep 확인(메모 정보 직접 기입!) : webapp 파드 tcp 3000

docker exec -it myk8s-control-plane sh -c "ngrep -tW byline -d veth37861f50 '' 'tcp port 3000'"

## webapp 파드가 catalog v1 요청

T 2025/04/26 11:27:34.274758 10.10.0.15:57714 -> 10.10.0.22:3000 [AP] #37

GET /items HTTP/1.1.

host: catalog.istioinaction:80.

user-agent: beegoServer.

x-envoy-attempt-count: 1.

x-forwarded-for: 172.18.0.1.

x-forwarded-proto: http.

x-request-id: 52efe2f7-e4d7-4fbd-ac44-9dab8815d827.

accept-encoding: gzip.

x-envoy-internal: true.

x-envoy-decorator-operation: catalog.istioinaction.svc.cluster.local:80/*.

x-envoy-peer-metadata: ChoKDkFQUF9DT05UQUlORVJTEggaBndlYmFwcAoaCgpDTFVTVEVSX0lEEgwaCkt1YmVybmV0ZXMKHAoMSU5TVEFOQ0VfSVBTEgwaCjEwLjEwLjAuMTUKGQoNSVNUSU9fVkVSU0lPThIIGgYxLjE3LjgKowEKBkxBQkVMUxKYASqVAQoPCgNhcHASCBoGd2ViYXBwCiQKGXNlY3VyaXR5LmlzdGlvLmlvL3Rsc01vZGUSBxoFaXN0aW8KKwofc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtbmFtZRIIGgZ3ZWJhcHAKLwojc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtcmV2aXNpb24SCBoGbGF0ZXN0ChoKB01FU0hfSUQSDxoNY2x1c3Rlci5sb2NhbAogCgROQU1FEhgaFndlYmFwcC03Njg1YmNiODQtZjJyZ3gKHAoJTkFNRVNQQUNFEg8aDWlzdGlvaW5hY3Rpb24KUAoFT1dORVISRxpFa3ViZXJuZXRlczovL2FwaXMvYXBwcy92MS9uYW1lc3BhY2VzL2lzdGlvaW5hY3Rpb24vZGVwbG95bWVudHMvd2ViYXBwChcKEVBMQVRGT1JNX01FVEFEQVRBEgIqAAoZCg1XT1JLTE9BRF9OQU1FEggaBndlYmFwcA==.

x-envoy-peer-metadata-id: sidecar~10.10.0.15~webapp-7685bcb84-f2rgx.istioinaction~istioinaction.svc.cluster.local.

x-b3-traceid: 1968f007bcf4f204b20684f4cfe6a51a.

x-b3-spanid: e309073fe0bceb57.

x-b3-parentspanid: 121d66f45b2404bf.

x-b3-sampled: 0.

.

## webapp 파드가 catalog v2 미러링 전달

T 2025/04/26 11:27:34.274794 10.10.0.15:44950 -> 10.10.0.23:3000 [AP] #38

GET /items HTTP/1.1.

host: catalog.istioinaction-shadow:80.

user-agent: beegoServer.

x-envoy-attempt-count: 1.

x-forwarded-for: 172.18.0.1,10.10.0.15.

x-forwarded-proto: http.

x-request-id: 52efe2f7-e4d7-4fbd-ac44-9dab8815d827.

accept-encoding: gzip.

x-envoy-internal: true.

x-envoy-decorator-operation: catalog.istioinaction.svc.cluster.local:80/*.

x-envoy-peer-metadata: ChoKDkFQUF9DT05UQUlORVJTEggaBndlYmFwcAoaCgpDTFVTVEVSX0lEEgwaCkt1YmVybmV0ZXMKHAoMSU5TVEFOQ0VfSVBTEgwaCjEwLjEwLjAuMTUKGQoNSVNUSU9fVkVSU0lPThIIGgYxLjE3LjgKowEKBkxBQkVMUxKYASqVAQoPCgNhcHASCBoGd2ViYXBwCiQKGXNlY3VyaXR5LmlzdGlvLmlvL3Rsc01vZGUSBxoFaXN0aW8KKwofc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtbmFtZRIIGgZ3ZWJhcHAKLwojc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtcmV2aXNpb24SCBoGbGF0ZXN0ChoKB01FU0hfSUQSDxoNY2x1c3Rlci5sb2NhbAogCgROQU1FEhgaFndlYmFwcC03Njg1YmNiODQtZjJyZ3gKHAoJTkFNRVNQQUNFEg8aDWlzdGlvaW5hY3Rpb24KUAoFT1dORVISRxpFa3ViZXJuZXRlczovL2FwaXMvYXBwcy92MS9uYW1lc3BhY2VzL2lzdGlvaW5hY3Rpb24vZGVwbG95bWVudHMvd2ViYXBwChcKEVBMQVRGT1JNX01FVEFEQVRBEgIqAAoZCg1XT1JLTE9BRF9OQU1FEggaBndlYmFwcA==.

x-envoy-peer-metadata-id: sidecar~10.10.0.15~webapp-7685bcb84-f2rgx.istioinaction~istioinaction.svc.cluster.local.

x-b3-traceid: 1968f007bcf4f204b20684f4cfe6a51a.

x-b3-spanid: 93f575a7c415f5e2.

x-b3-parentspanid: e309073fe0bceb57.

x-b3-sampled: 0.

.

## catalog v1 에서 응답 받음

T 2025/04/26 11:27:34.275973 10.10.0.22:3000 -> 10.10.0.15:57714 [AP] #40

HTTP/1.1 200 OK.

x-powered-by: Express.

vary: Origin, Accept-Encoding.

access-control-allow-credentials: true.

cache-control: no-cache.

pragma: no-cache.

expires: -1.

content-type: application/json; charset=utf-8.

content-length: 502.

etag: W/"1f6-ih2h+hDQ0yLLcKIlBvwkWbyQGK4".

date: Sat, 26 Apr 2025 11:27:34 GMT.

x-envoy-upstream-service-time: 0.

x-envoy-peer-metadata: ChsKDkFQUF9DT05UQUlORVJTEgkaB2NhdGFsb2cKGgoKQ0xVU1RFUl9JRBIMGgpLdWJlcm5ldGVzChwKDElOU1RBTkNFX0lQUxIMGgoxMC4xMC4wLjIyChkKDUlTVElPX1ZFUlNJT04SCBoGMS4xNy44CrIBCgZMQUJFTFMSpwEqpAEKEAoDYXBwEgkaB2NhdGFsb2cKJAoZc2VjdXJpdHkuaXN0aW8uaW8vdGxzTW9kZRIHGgVpc3RpbwosCh9zZXJ2aWNlLmlzdGlvLmlvL2Nhbm9uaWNhbC1uYW1lEgkaB2NhdGFsb2cKKwojc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtcmV2aXNpb24SBBoCdjEKDwoHdmVyc2lvbhIEGgJ2MQoaCgdNRVNIX0lEEg8aDWNsdXN0ZXIubG9jYWwKIgoETkFNRRIaGhhjYXRhbG9nLTZkNWI5YmJiNjYtd213emwKHAoJTkFNRVNQQUNFEg8aDWlzdGlvaW5hY3Rpb24KUQoFT1dORVISSBpGa3ViZXJuZXRlczovL2FwaXMvYXBwcy92MS9uYW1lc3BhY2VzL2lzdGlvaW5hY3Rpb24vZGVwbG95bWVudHMvY2F0YWxvZwoXChFQTEFURk9STV9NRVRBREFUQRICKgAKGgoNV09SS0xPQURfTkFNRRIJGgdjYXRhbG9n.

x-envoy-peer-metadata-id: sidecar~10.10.0.22~catalog-6d5b9bbb66-wmwzl.istioinaction~istioinaction.svc.cluster.local.

server: istio-envoy.

.

[

{

"id": 1,

"color": "amber",

"department": "Eyewear",

"name": "Elinor Glasses",

"price": "282.00"

},

...

## catalog v2 에서 응답 받음

T 2025/04/26 11:27:34.275973 10.10.0.23:3000 -> 10.10.0.15:44950 [AP] #39

HTTP/1.1 200 OK.

x-powered-by: Express.

vary: Origin, Accept-Encoding.

access-control-allow-credentials: true.

cache-control: no-cache.

pragma: no-cache.

expires: -1.

content-type: application/json; charset=utf-8.

content-length: 698.

etag: W/"2ba-8igEisu4O69h8jWIFgUqgmp7D5o".

date: Sat, 26 Apr 2025 11:27:34 GMT.

x-envoy-upstream-service-time: 0.

x-envoy-peer-metadata: ChsKDkFQUF9DT05UQUlORVJTEgkaB2NhdGFsb2cKGgoKQ0xVU1RFUl9JRBIMGgpLdWJlcm5ldGVzChwKDElOU1RBTkNFX0lQUxIMGgoxMC4xMC4wLjIzChkKDUlTVElPX1ZFUlNJT04SCBoGMS4xNy44CrIBCgZMQUJFTFMSpwEqpAEKEAoDYXBwEgkaB2NhdGFsb2cKJAoZc2VjdXJpdHkuaXN0aW8uaW8vdGxzTW9kZRIHGgVpc3RpbwosCh9zZXJ2aWNlLmlzdGlvLmlvL2Nhbm9uaWNhbC1uYW1lEgkaB2NhdGFsb2cKKwojc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtcmV2aXNpb24SBBoCdjIKDwoHdmVyc2lvbhIEGgJ2MgoaCgdNRVNIX0lEEg8aDWNsdXN0ZXIubG9jYWwKJQoETkFNRRIdGhtjYXRhbG9nLXYyLTZkZjg4NWI1NTUtNnNxbnYKHAoJTkFNRVNQQUNFEg8aDWlzdGlvaW5hY3Rpb24KVAoFT1dORVISSxpJa3ViZXJuZXRlczovL2FwaXMvYXBwcy92MS9uYW1lc3BhY2VzL2lzdGlvaW5hY3Rpb24vZGVwbG95bWVudHMvY2F0YWxvZy12MgoXChFQTEFURk9STV9NRVRBREFUQRICKgAKHQoNV09SS0xPQURfTkFNRRIMGgpjYXRhbG9nLXYy.

x-envoy-peer-metadata-id: sidecar~10.10.0.23~catalog-v2-6df885b555-6sqnv.istioinaction~istioinaction.svc.cluster.local.

server: istio-envoy.

.

[

{

"id": 1,

"color": "amber",

"department": "Eyewear",

"name": "Elinor Glasses",

"price": "282.00",

"imageUrl": "http://lorempixel.com/640/480"

},

...

Routing to services outside your cluster by using Istio’s service discovery

- 외부 트래픽을 차단하도록 이스티오를 설정해 메시에 간단한 보호 계층을 더해보자

# 현재 istiooperators meshConfig 설정 확인

kubectl get istiooperators -n istio-system -o json

...

"meshConfig": {

"defaultConfig": {

"proxyMetadata": {}

},

"enablePrometheusMerge": true

},

...

# webapp 파드에서 외부 다운로드

kubectl exec -it deploy/webapp -n istioinaction -c webapp -- wget https://raw.githubusercontent.com/gasida/KANS/refs/heads/main/msa/sock-shop-demo.yaml

# webapp 로그 : 신규 터미널

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

[2025-04-19T09:55:34.851Z] "- - -" 0 UH - - "-" 0 0 0 - "-" "-" "-" "-" "-" BlackHoleCluster - 185.199.109.133:443 10.10.0.19:34868 - -

# 다음 명령을 실행해 이스티오의 기본값을 ALLOW_ANY 에서 REGISTRY_ONLY 로 바꾸자.

# 이느 서비스 메시 저장소에 명시적으로 허용된 경우(화이트 리스트)에만 트래픽이 메시를 떠나도록 허용하겠다는 의미다.

# 아래 설정 방법 이외에도 IstioOperator 로 설정을 변경하거나, istio-system 의 istio configmap 을 변경해도 됨.

# outboundTrafficPolicy 3가지 모드 : ALLOW_ANY (default) , REGISTRY_ONLY , ALLOW_LIST

docker exec -it myk8s-control-plane bash

----------------------------------------

istioctl install --set profile=default --set meshConfig.outboundTrafficPolicy.mode=REGISTRY_ONLY

y

exit

----------------------------------------

# 배포 확인

docker exec -it myk8s-control-plane istioctl proxy-status

NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION

catalog-6d5b9bbb66-vzg4j.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-8d74787f-6w77x 1.17.8

catalog-v2-6df885b555-n9nxw.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-8d74787f-6w77x 1.17.8

istio-ingressgateway-6bb8fb6549-s4pt8.istio-system Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-8d74787f-6w77x 1.17.8

webapp-7685bcb84-skzgg.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-8d74787f-6w77x 1.17.8

# webapp 파드에서 외부 다운로드

kubectl exec -it deploy/webapp -n istioinaction -c webapp -- wget https://raw.githubusercontent.com/gasida/KANS/refs/heads/main/msa/sock-shop-demo.yaml

Connecting to raw.githubusercontent.com (185.199.109.133:443)

wget: error getting response: Connection reset by peer

command terminated with exit code 1

# webapp 로그 : BlackHoleCluster 차단

# UH : NoHealthyUpstream - No healthy upstream hosts in upstream cluster in addition to 503 response code.

# https://www.envoyproxy.io/docs/envoy/latest/configuration/observability/access_log/usage

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

[2025-04-19T09:55:34.851Z] "- - -" 0 UH - - "-" 0 0 0 - "-" "-" "-" "-" "-" BlackHoleCluster - 185.199.109.133:443 10.10.0.19:34868 - -

# proxy-config : webapp

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn BlackHoleCluster -o json

[

{

"name": "BlackHoleCluster",

"type": "STATIC",

"connectTimeout": "10s"

}

]

# 현재 istiooperators meshConfig 설정 확인

kubectl get istiooperators -n istio-system -o json

...

"meshConfig": {

"accessLogFile": "/dev/stdout",

"defaultConfig": {

"proxyMetadata": {}

},

"enablePrometheusMerge": true,

"extensionProviders": [

{

"envoyOtelAls": {

"port": 4317,

"service": "opentelemetry-collector.istio-system.svc.cluster.local"

},

"name": "otel"

},

{

"name": "skywalking",

"skywalking": {

"port": 11800,

"service": "tracing.istio-system.svc.cluster.local"

}

}

],

"outboundTrafficPolicy": {

"mode": "REGISTRY_ONLY"

}

},

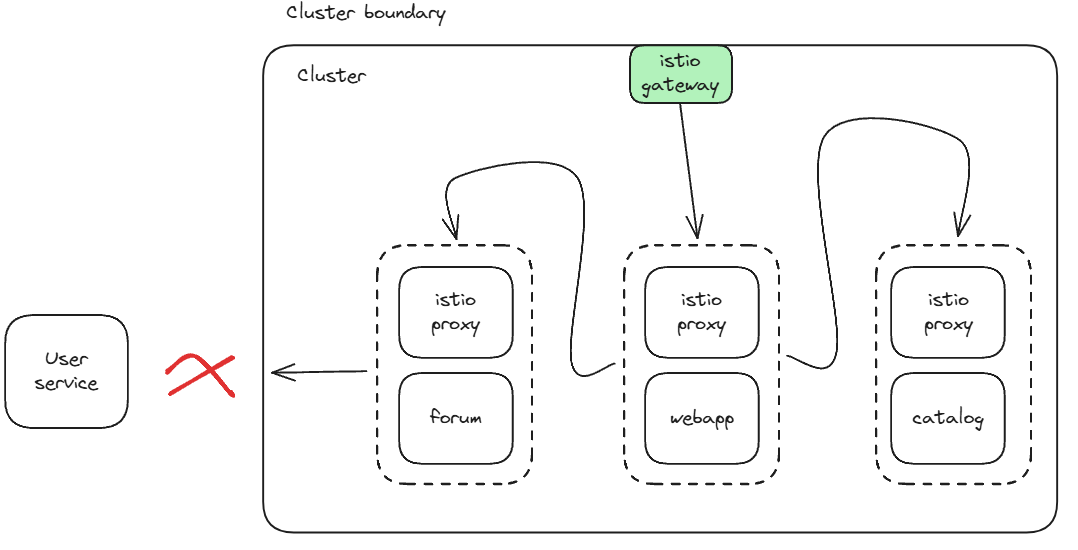

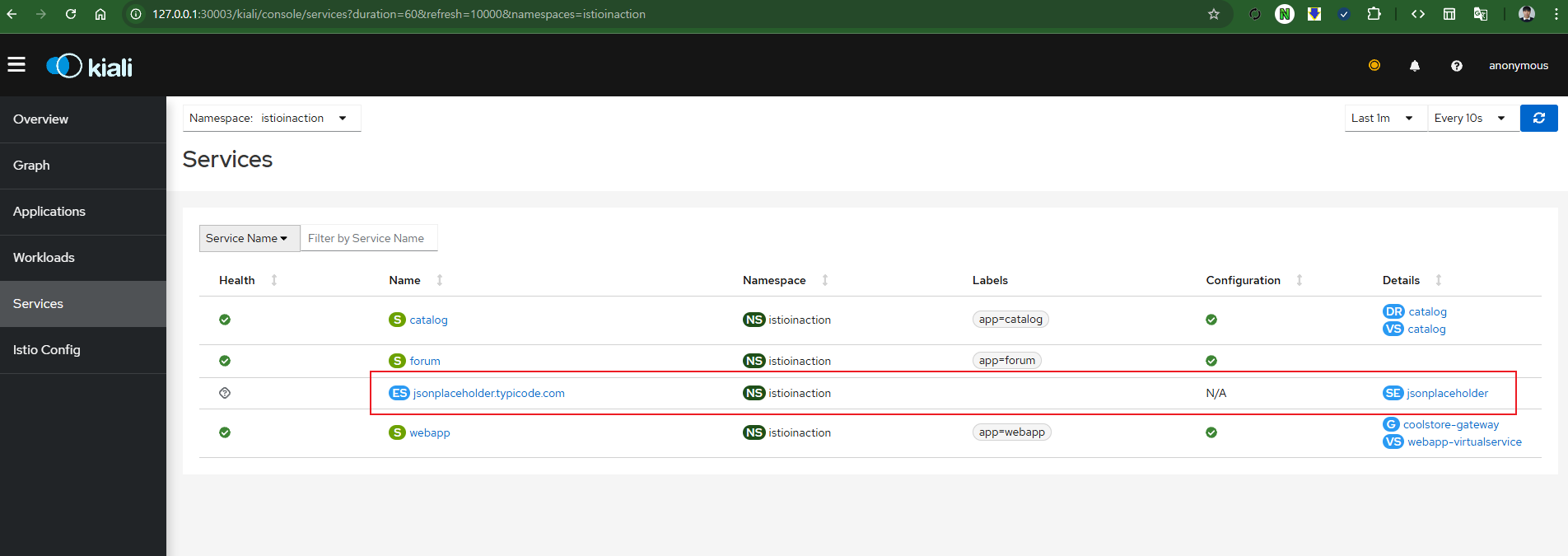

- ServiceEntry : 이스티오의 서비스 디스커버리 기능을 사용해 클러스터 외부의 서비스로 라우팅하기

- 모든 서비스가 서비스 메시 내에 있는 것은 아니므로, 메시 내부의 서비스가 메시 외부의 서비스와 통신할 방법이 필요하다.

- 메시 외부의 서비스는 기존 HTTP 서비스일 수도 있고, 데이터베이스나 캐시 같은 인프라 서비스일 수도 있다.

- 이스티오 외부에 위치한 서비스에 대해서도 정교한 라우팅을 구현할 수 있는데, 먼저 ServiceEntry 라는 개념부터 소개해야 한다.

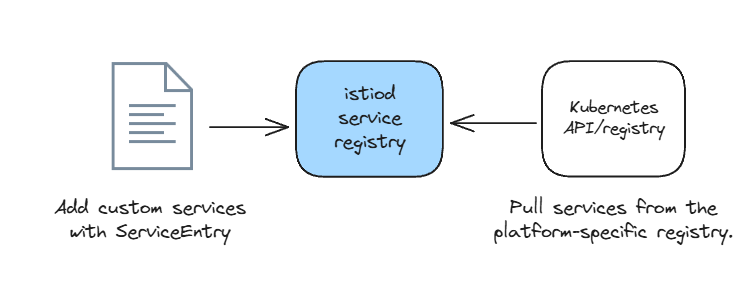

- 이스티오는 내부 서비스 저장소 internal service registry 를 구축하는데, 여기에는 메시에서 인지하고 접근할 수 있는 모든 서비스가 들어 있다.

- 이 저장소가 메시 내 서비스가 다른 서비스를 찾는 데 사용 할 수 있는 서비스 디스커버리 저장소의 공식적인 표현이라고 생각해도 좋다.

- You can think of this registry as the canonical representation of a service-discovery registry that services within the mesh can use to find other services.

- 이스티오는 컨트롤 플레인을 배포한 플랫폼을 보고 내부 저장소를 구축한다.

- Istio builds this internal registry by making assumptions about the platform on which the control plane is deployed.

- 예를 들어 이 책에서는 컨트롤 플레인을 쿠버네티스에 배포하고 있다.

- 이스티오는 기본 쿠버네티스 API를 사용해 자신의 서비스 카탈로그를 구축한다. 이는 그림 5.12에서 보여지는 것과 같다.

- 메시 내부의 서비스가 메시 외부의 서비스와 통신하려면, 이스티오의 서비스 디스커버리 저장소가 이 외부 서비스를 인지하게 해야 한다.

- Istio uses the default Kubernetes API to build its catalog of services (based on Kubernetes Service objects)

- 실습시나리오

- 이를 위해 서비스 메시 클러스터 외부에 구축하고 배포한 온라인 포럼에 사용자를 연결할 것이다.

- 여기서 포럼은 jsonplaceholder.typicode.com URL에 있다. Free fake and reliable API for testing and prototyping.

- API 개발 및 테스트를 쉽게 할 수 있도록 가짜 데이터(Fake Data) REST API 형태로 제공해주는 무료 서비스.

- 각 엔드포인트는 GET, POST, PUT, DELETE 같은 메서드도 흉내낼 수 있지만 실제 데이터는 저장되지는 않음. (가상의 응답만 리턴)

- 다음과 같은 리소스 엔드포인트를 제공

| 리소스 | 설명 | 예시 요청 |

| /posts | 게시글 목록 | GET /posts |

| /comments | 댓글 목록 | GET /comments |

| /albums | 앨범 목록 | GET /albums |

| /photos | 사진 정보 | GET /photos |

| /todos | 할일 목록 | GET /todos |

| /users | 사용자 정보 | GET /users |

- ServiceEntry 리소스는 이스티오의 서비스 저장소에 항목을 삽입하는 데 사용 할 수 있는 저장소 메타데이터를 캡슐화

# cat ch5/forum-serviceentry.yaml

apiVersion: networking.istio.io/v1alpha3

kind: ServiceEntry

metadata:

name: jsonplaceholder

spec:

hosts:

- jsonplaceholder.typicode.com

ports:

- number: 80

name: http

protocol: HTTP

resolution: DNS

location: MESH_EXTERNAL- 이 ServiceEntry 리소스는 항목을 이스티오 서비스 저장소에 삽입하는데, 이는 메시 내 클라이언트가 호스트 jsonplaceholder.typicode.com 를 사용해 JSON 플레이스홀더를 호출할 수 있음을 명시한다.

- JSON 플레이스홀더 서비스는 클러스터 외부에 있는 서비스와의 통신을 실험하는 데 사용할 수 있도록 예제 REST API를 노출한다.

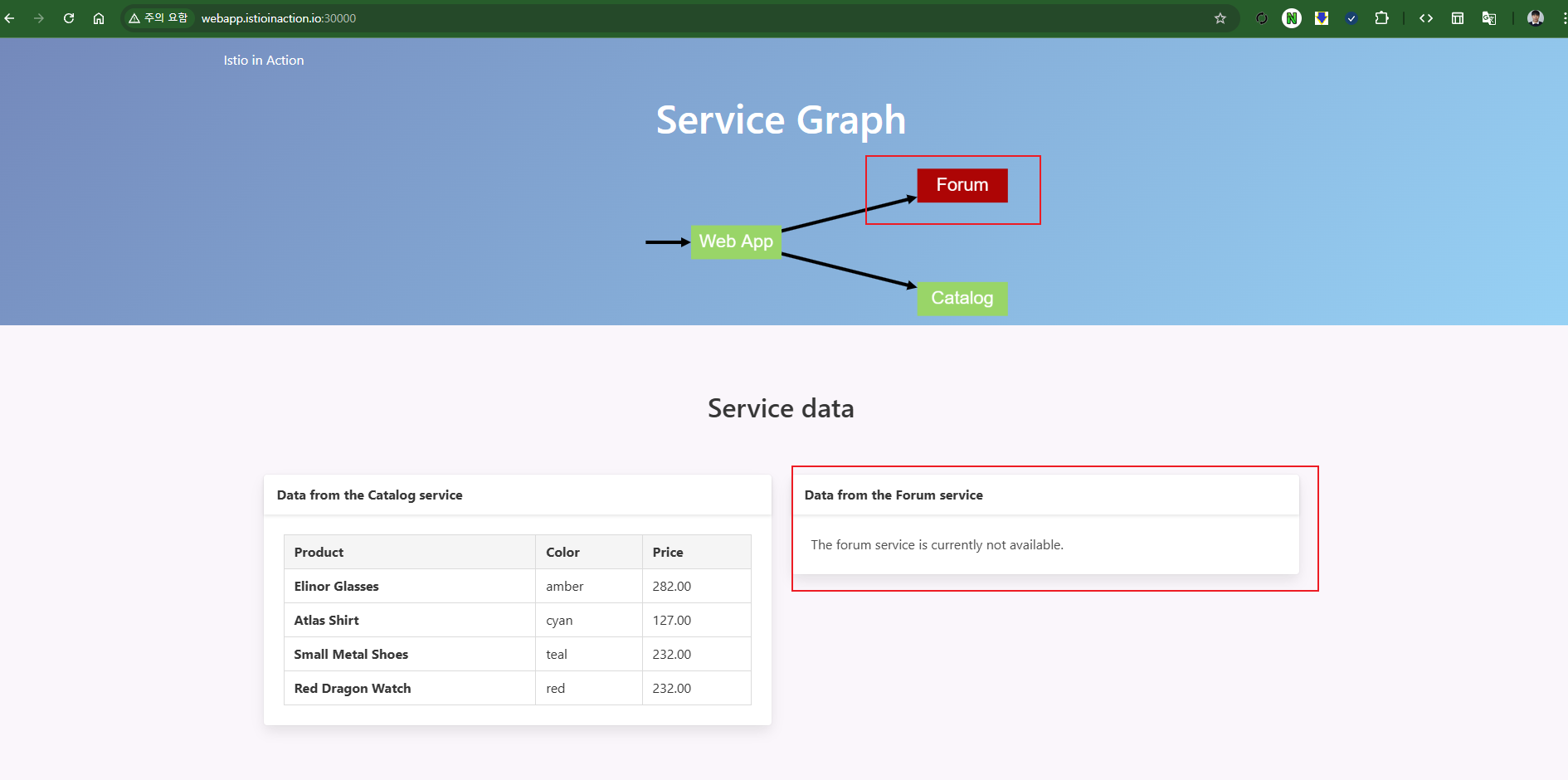

- 이 ServiceEntry를 만들기 전에 jsonplaceholder.typicode.com REST API를 호출하는 서비스를 설치하고, 이스티오가 실제로 밖으로 나가는 모든 트래픽을 막는지 관찰해보자.

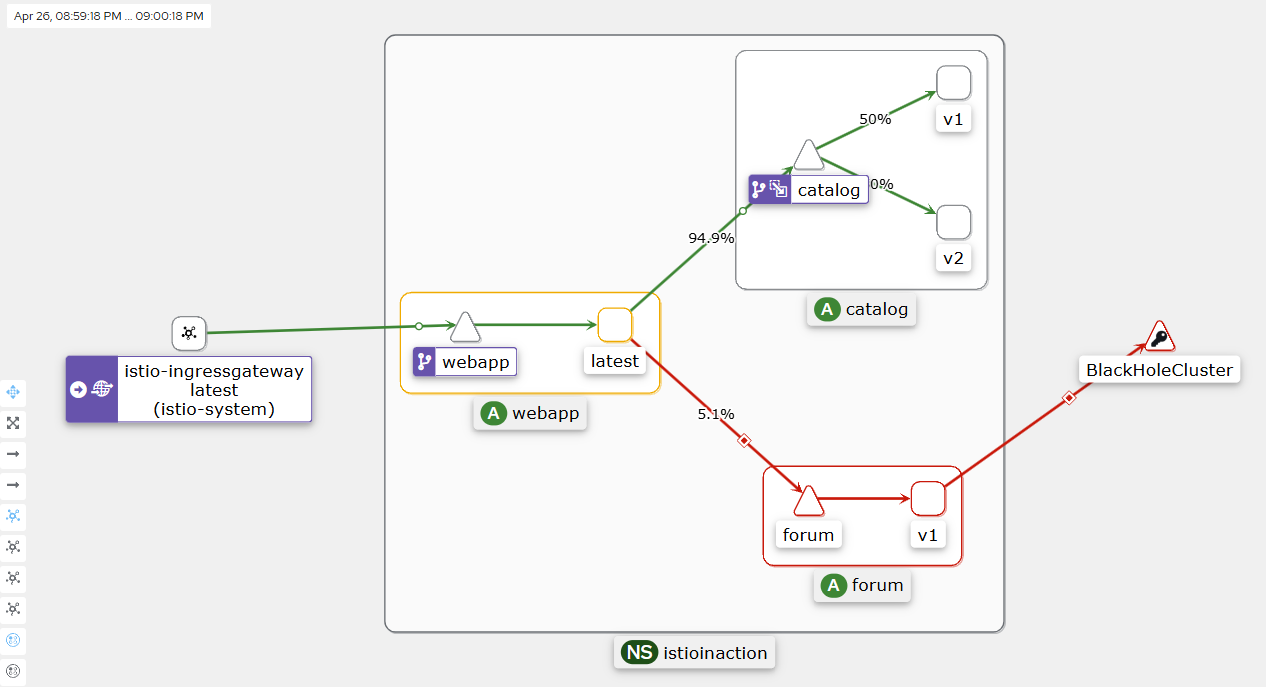

- 실습

- jsonplaceholder.typicode.com 을 사용하는 예시 포럼 애플리케이션을 설치

# forum 설치

cat services/forum/kubernetes/forum-all.yaml

kubectl apply -f services/forum/kubernetes/forum-all.yaml -n istioinaction

# 확인

kubectl get deploy,svc -n istioinaction -l app=webapp

docker exec -it myk8s-control-plane istioctl proxy-status

# webapp 웹 접속

open http://webapp.istioinaction.io:30000/

- 메시 안에서 새로운 포럼 서비스를 호출해보자

# 메시 안에서 새로운 포럼 서비스를 호출

curl -s http://webapp.istioinaction.io:30000/api/users

error calling Forum service

# forum 로그 확인

kubectl logs -n istioinaction -l app=forum -c istio-proxy -f

[2025-04-19T10:35:23.526Z] "GET /users HTTP/1.1" 502 - direct_response - "-" 0 0 0 - "172.18.0.1" "Go-http-client/1.1" "04bef923-b182-94e9-a58d-e2d9f957693b" "jsonplaceholder.typicode.com" "-" - - 104.21.48.1:80 172.18.0.1:0 - block_all

# 클러스터 내부 서비스에서 외부 도메인(jsonplaceholder.typicode.com) 으로 나가려 했지만, Istio가 요청을 막아서 502 오류와 함께 직접 응답 처리한 상황

## direct_response : Envoy가 요청을 외부로 보내지 않고 자체적으로 차단 응답을 반환했음을 의미

## block_all : Istio에서 egress(외부) 요청이 전면 차단됨을 나타내는 메시지

[2025-04-19T10:35:23.526Z] "GET /api/users HTTP/1.1" 500 - via_upstream - "-" 0 28 0 0 "172.18.0.1" "beegoServer" "04bef923-b182-94e9-a58d-e2d9f957693b" "forum.istioinaction:80" "10.10.0.31:8080" inbound|8080|| 127.0.0.6:60487 10.10.0.31:8080 172.18.0.1:0 - default

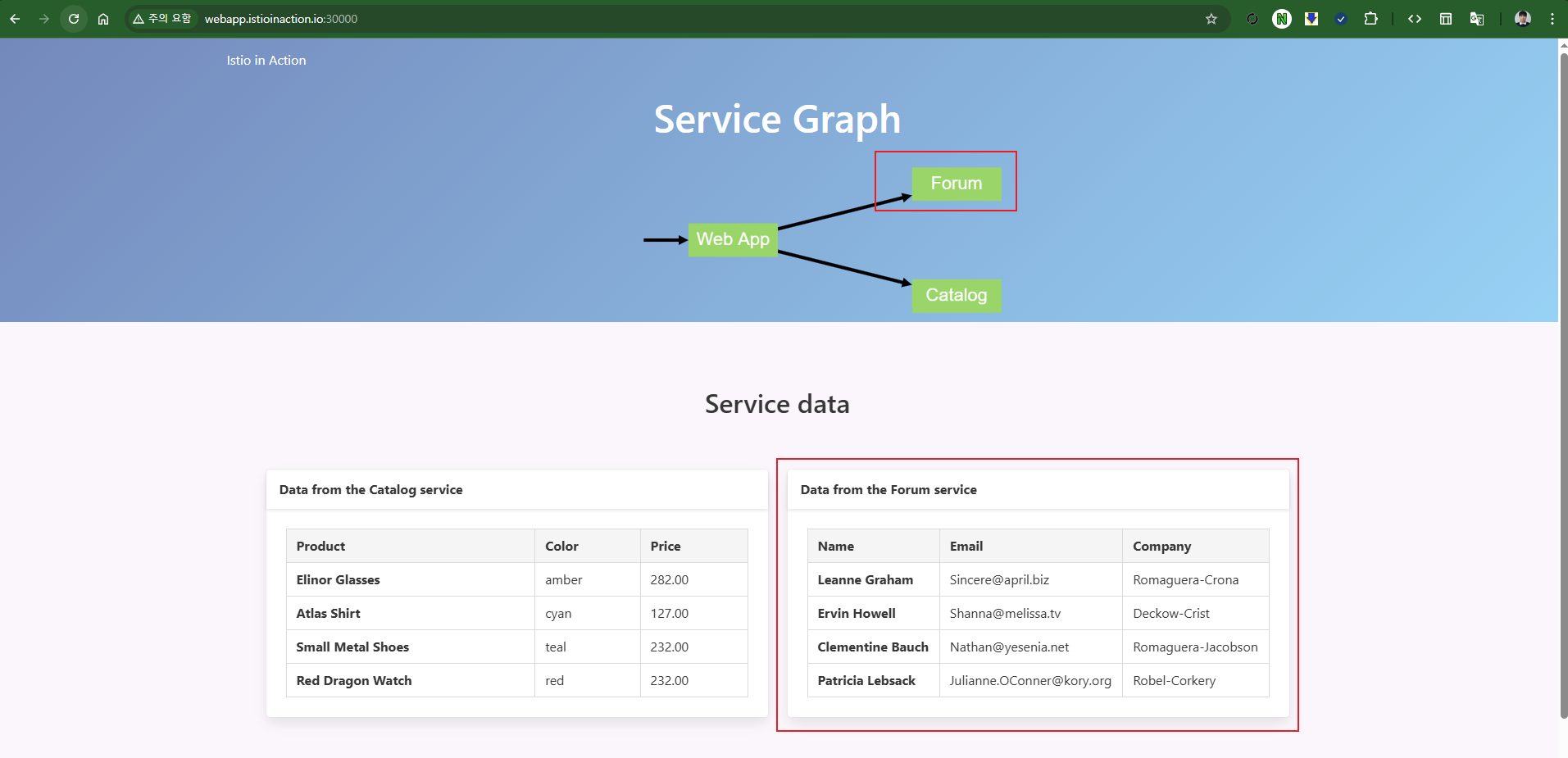

- 이 호출을 허용하기 위해 jsonplaceholder.typicode.com 호스트에 이스티오 ServiceEntry 리소스를 만들 수 있다.

- ServiceEntry 리소스를 만들면 이스티오의 서비스 저장소에 항목이 삽입되고, 서비스 메시가 이를 알 수 있다.

# istio proxy (forum)

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/forum.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/forum.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/forum.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config all deploy/forum.istioinaction -o short > forum-1.json

#

cat ch5/forum-serviceentry.yaml

apiVersion: networking.istio.io/v1alpha3

kind: ServiceEntry

metadata:

name: jsonplaceholder

spec:

hosts:

- jsonplaceholder.typicode.com

ports:

- number: 80

name: http

protocol: HTTP

resolution: DNS

location: MESH_EXTERNAL

kubectl apply -f ch5/forum-serviceentry.yaml -n istioinaction

#

docker exec -it myk8s-control-plane istioctl proxy-config all deploy/forum.istioinaction -o short > forum-2.json

diff forum-1.json forum-2.json

25a26

> jsonplaceholder.typicode.com 80 - outbound STRICT_DNS

96a98

> 80 jsonplaceholder.typicode.com /*

#

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/forum.istioinaction | grep json

80 jsonplaceholder.typicode.com /*

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/forum.istioinaction --fqdn jsonplaceholder.typicode.com -o json

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/forum.istioinaction | grep json

jsonplaceholder.typicode.com 80 - outbound STRICT_DNS

# 목적 hosts 의 도메인 질의 응답 IP로 확인된 엔드포인트들 확인

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/forum.istioinaction --cluster 'outbound|80||jsonplaceholder.typicode.com'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

104.21.112.1:80 HEALTHY OK outbound|80||jsonplaceholder.typicode.com

104.21.16.1:80 HEALTHY OK outbound|80||jsonplaceholder.typicode.com

104.21.32.1:80 HEALTHY OK outbound|80||jsonplaceholder.typicode.com

104.21.48.1:80 HEALTHY OK outbound|80||jsonplaceholder.typicode.com

104.21.64.1:80 HEALTHY OK outbound|80||jsonplaceholder.typicode.com

104.21.80.1:80 HEALTHY OK outbound|80||jsonplaceholder.typicode.com

104.21.96.1:80 HEALTHY OK outbound|80||jsonplaceholder.typicode.com

# 메시 안에서 새로운 포럼 서비스를 호출 : 사용자 목록 반환 OK

curl -s http://webapp.istioinaction.io:30000/api/users

# 반복 접속

while true; do curl -s http://webapp.istioinaction.io:30000/ ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done

# webapp 웹 접속

open http://webapp.istioinaction.io:30000/

- Summary

- DestinationRule 로 워크로드를 v1, v2 버전과 같이 더 작은 부분집합들로 분리할 수 있다.

- VirtualService는 이런 부분집합들을 사용해 트래픽을 세밀하게 라우팅한다.

- VirtualService는 HTTP 헤더 같은 애플리케이션 계층 정보를 기반으로 라우팅 결정을 설정한다.

- 이 덕분에 베타 테스터 같은 특정 사용자 집합을 서비스의 신 버전으로 보내 테스트하는 다크 런치 기법을 사용할 수 있다.

- 가중치 라우팅(VirtualService 리소스로 설정)을 사용하는 서비스 프록시는 트래픽을 점진적으로 새 배포로 라우팅할 수 있는데, 덕분에 카나리 배포(트래픽 전환이라고도 함) 같은 방법을 사용할 수 있다.

- 트래픽 전환은 Flagger를 사용해 자동화할 수 있다. Flagger는 수집한 메트릭을 사용해 새 배포로 라우팅되는 트래픽을 점진적으로 늘리는 오픈소스 솔루션이다.

- outboundTrafficPolicy 를 REGISTER_ONLY로 설정하면 어떤 트래픽도 클러스터를 떠나지 못하게 함으로써 악의적인 사용자가 외부로 정보를 전송하는 것을 방지할 수 있다.

- outboundTrafficPolicy 를 REGISTER_ONLY로 설정했을 때는 ServiceEntry로 외부로 향하는 트래픽을 허용할 수 있다.

728x90

'2025_Istio Hands-on Study' 카테고리의 다른 글

| 3주차 - Resilience(2) (0) | 2025.04.27 |

|---|---|

| 3주차 - Resilience(1) (0) | 2025.04.26 |

| 3주차 - Traffic control(2) (0) | 2025.04.26 |

| 3주차 - Traffic control(1) (0) | 2025.04.25 |

| 2주차 - Envoy, Isto Gateway(3) (0) | 2025.04.22 |